السر المظلم في قلب الذكاء الاصطناعي

لا أحد يعرف، على وجه اليقين، كيف تقوم الخوارزميات المتطورة بما تقوم به. ربما تكون هذه مشكلة خطيرة، لأن أجهزة الحاسوب صارت مسؤولة أكثر من أي وقت مضى عن اتخاذ قرارات على جانب كبير من الأهمية.

في العام الماضي انطلقت سيارة غريبة ذاتية القيادة تجوب الطرق الهادئة في مقاطعة مونموث بولاية نيو جيرسي. فالمركبة التجريبية التي طورها باحثون في شركة صناعة الشرائح نفيديا NVidia، لم تبدُ مختلفة عن السيارات ذاتية القيادة، لكنها اختلفت تماماً عن النماذج التي قدمتها شركات غوغل Google وتيسلا Tesla وجنرال موتورز General Motors، وأكدت القدرات المتزايدة للذكاء الاصطناعي. ولم تتبع السيارة أي تعليمات من المهندسين والمبرمجين، بل اعتمدت كلياً على خوارزمية علَّمَت نفسها قيادة السيارة عبر مشاهدة إنسان يقود السيارة.

تمكين سيارة من القيادة بهذه الطريقة إنجاز رائع، لكنه أيضاً مثير للقلق بعض الشيء، لعدم وضوح كيفية اتخاذ السيارة قراراتها. فالمعلومات المُحصَّلة من أجهزة الاستشعار في السيارة تذهب مباشرة إلى شبكة ضخمة من الخلايا العصبية الاصطناعية التي تعالج البيانات، وتُسلم الأوامر المطلوبة لتشغيل عجلة القيادة والفرامل وغيرها من الأنظمة الأخرى.

والنتيجة توافق الاستجابات المتوقعة من إنسان يقود سيارة، لكن ماذا لو فعلت السيارة شيئاً غير متوقع يوماً ماً، مثل الارتطام بشجرة أو الوقوف عند إشارة المرور الخضراء؟ ربما يكون من الصعب معرفة السبب كما هي الحال الآن، فالنظام معقد جداً لدرجة يجد معها المهندسون الذين صمموه صعوبةً في تحديد السبب وراء أي فعلٍ من أفعاله. كما لا يمكن توجيه الأسئلة له، نظراً لغياب طريقة واضحةٍ لتصميم نظام يفسِّر ما فعله.

ويشير عقل هذه السيارة الغامض إلى قضية تلوح في أفق الذكاء الاصطناعي، فقد أثبتت تكنولوجيا الذكاء الاصطناعي الكامنة في السيارة، والمعروفة بالتعلم العميق Deep Learning، أنها قادرة على حل المشكلات بفاعلية في السنوات الأخيرة، ما أدى إلى استخدامها على نطاق واسع في مهام مثل: وضع تعليقات توضيحية على الصور وتمييز الأصوات والترجمة. الآن، هناك أمل بأن تكون هذه التقنيات نفسها قادرة على تشخيص الأمراض القاتلة، واتخاذ قرارات تجارية بملايين الدولارات، والقيام بأمور أخرى تُغيِّر وجه صناعات بأكملها.

لكن هذا لن يحدث – أو لا ينبغي أن يحدث – ما لم نجد سبيلاً لجعل تقنياتٍ مثل التعلم العميق مفهومة أكثر لدى صانعيها وخاضعة للمساءلة من طرف مستخدميها، وإلا سيكون من الصعب التنبؤ بأوقات حدوث الفشل، الأمر الذي لا مفر منه، وهو أحد أسباب بقاء سيارة إنفيديا في طورٍ تجريبي.

تُستخدم النماذج الرياضياتية بالفعل في المساعدة على تحديد الحاصلين على إطلاق السراح المشروط، والمؤهلين للحصول على قروض، ومن يتم توظيفهم. وإذا أمكن الولوج إلى هذه النماذج الرياضياتية، فسيصبح فهم طريقة تفكيرها ممكناً، لكن البنوك والجيش وأرباب العمل وغيرهم يوجهون اهتمامهم الآن إلى مقاربات أكثر تعقيداً للتعلم الآلي، يمكن أن تجعل اتخاذ القرارات بطريقة آلية أمراً يستعصي على الفهم.

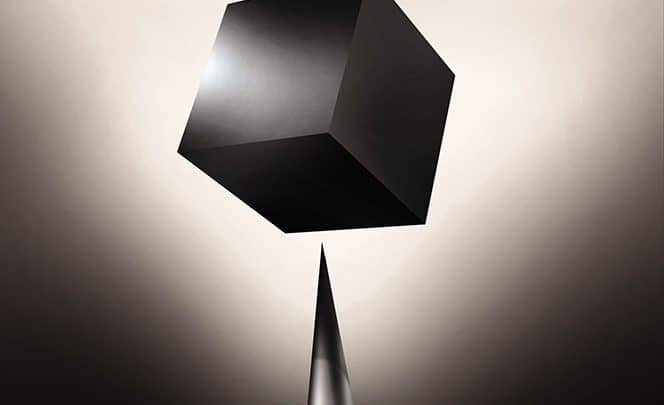

يقدم التعلم العميق، أكثر هذه المقاربات شيوعاً، نهجاً مختلفاً في برمجة أجهزة الحاسوب، ويقول تومي جاكولا Tommi Jaakkola، الأستاذ في معهد ماساتشوستس للتكنولوجيا، والذي يعمل على تطبيقات التعلم الآلي: “إنها مشكلة قائمة بالفعل، وستكون أكثر أهمية في المستقبل.” ويتابع قائلا: “وسواءٌ أكان قراراً استثمارياً أم طبياً، أم عسكرياً، فلا أحد يريد الاعتماد فقط على طريقة الصندوق الأسود.”

هناك بالفعل حجة ترى أن القدرة على استجواب أنظمة الذكاء الاصطناعي حول كيفية توصلها إلى استنتاجاتها هي حق قانوني أساسي. وبدايةً من صيف عام 2018، قد يُلزم الاتحاد الأوروبي الشركات بأن تقدم للمستخدمين تفسيراً للقرارات التي تنفذها أنظمتها الآلية. لكن هذا قد يكون مستحيلاً، حتى بالنسبة إلى الأنظمة التي تبدو بسيطة نسبياً على السطح، مثل التطبيقات ومواقع الإنترنت التي تستخدم التعلم العميق في خدمة الإعلانات أو اقتراح الأغاني، فأجهزة الحاسوب التي تدير هذه الخدمات برمجت نفسها بطرقٍ لا يسعنا فهمها، وحتى المهندسون الذين يصممون هذه التطبيقات عاجزون عن تفسير سلوكها.

ويثير هذا أسئلةً محيرةً للعقل. فمع تقدم هذه التكنولوجيا، قد نتخطى قريباً تلك العتبة التي يصير استخدام الذكاء الاصطناعي بعدها أمراً يتطلب قفزة إلى المجهول بإيمان بإمكانية النجاح. وبالتأكيد، نحن البشر، لا يمكن أن نفسر دائماً عمليات التفكير التي تحدث داخل عقولنا، لكننا نجد سبلاً إلى الثقة بالآخرين وتقييمهم تعتمد على الحدس، فهل يكون هذا ممكناً مع آلات تفكر وتتخذ قرارات بطريقةٍ تختلف عن طريقة الإنسان؟ لم يسبق لنا قطُّ صنع آلات تستعصي على فهم صانعيها. فلأي مدى يمكننا توقع التواصل والاتفاق مع آلات ذكية، قد يكون سلوكها متقلباً ومبهماً؟ هذه الأسئلة أخذتني في رحلة إلى طليعة الأبحاث عن خوارزميات الذكاء الاصطناعي، من غوغل إلى آبل وأماكن أخرى كثيرة، بما في ذلك لقاءٌ مع واحد من أهم الفلاسفة عصرنا.

في عام 2015، طبّق فريق بحثي في مستشفى ماونت سيناي Mount Sinai بمدينة نيويورك، التعلمَ العميق على قاعدة البيانات الضخمة الخاصة بسجلات المرضى، والتي تحتوي على مئات من المتغيرات المستمدة من نتائج الاختبارات وزيارات الأطباء وغيرها. فقد جرى تدريب البرنامج الناتج الذي سمّاه الباحثون (المريض العميق) Deep Patient باستخدام بيانات نحو سبعمائة ألف مريض. وأثبت عند اختباره على سجلات جديدة أن قدرته على التنبؤ بالأمراض جيدة جداً. دون أي تعليمات مسبقة من الخبراء، اكتشف هذا النظام أنماطاً مخبأة داخل بيانات المستشفى يبدو أنها تشير إلى متى يكون الناس في طريقهم إلى الإصابة بمجموعة مختلفة من الأمراض، بما فيها سرطان الكبد. فهناك منهجيات “جيدة جداً” في التنبؤ بالأمراض، اعتماداً على سجلات المرضى، وفقاً لجويل دادلي Joel Dudley، قائد الفريق البحثي بمستشفى ماونت سيناي، لكنه يضيف قائلا إن النظام الجديد “كان أفضل منها بكثير.”

وفي الوقت نفسه، فإن البرنامج Deep Patient محير بعض الشيء. إذ يبدو أنه يتوقع ظهور الاضطرابات النفسية مثل الفصام Schizophrenia على نحو جيد. ولكن لما كان التنبؤ بالفصام معروف بصعوبة تنبؤ الأطباء بحدوثه، ويتساءل دادلي كيف يكون مثل ذلك ممكنا. ولا يزال لا يعرف. ولا تقدم هذه الأداة الجديدة أي توضيح عن كيفية قيامها بهذا. وإذآ كان هناك شيءٌ مثل البرنامج Deep Patient سيساعد الأطباء، فمن المفضَّل أن يكون قادراً على تقديم أساس منطقي لتنبؤاته، من أجل طمأنتهم إلى دقته، وتبرير أي تغيير في الأدوية التي توصف للمرضى على سبيل المثال. ويقول دادلي بأسف: “يمكننا بناء هذه النماذج، لكننا لا نفهم كيفية عملها.”

لم يكن الذكاء الاصطناعي على هذا النحو دائماً. فقد كانت هناك منذ البداية مدرستان فكريتان تتساءلان حول الكيفية التي ينبغي أن يكون عليها الذكاء الاصطناعي فيما يتعلق بإمكانية فهمه وتفسيره. ورأى كثيرون أن الخيار الأكثر منطقية هو بناء آلات تفكر وفقاً للقواعد والمنطق، ما يجعل كيفية عملها واضحةً لأي شخص يهتم بفحص شيفرتها Codes. بينما رأى آخرون أن الذكاء سيظهر بسهولة أكبر إذا استلهمت الآلات من علم الأحياء، وتعلمت عن طريق المراقبة والتجربة، ما يعني قلب كيفية برمجة الحاسوب رأساً على عقب. وبدلاً من تدخل مبرمج لكتابة أوامر معينة بهدف حل مشكلة ما، يولِّد البرنامج خوارزميات خاصة به، اعتماداً على بيانات سابقة ووفق المخرجات المطلوبة. وقد اتبعت تقنيات التعلم الآلي Machine Learning – التي تطورت في وقت لاحق إلى أقوى برامج الذكاء الاصطناعي في يومنا هذا- هذا المسار: الآلة جوهريا تبرمج نفسها.

وفي البداية، كانت لهذه المقاربة تطبيقات عملية محدودة، وفي الستينات والسبعينات، ظلت محصورة إلى حدٍ كبير داخل نطاق التخصص. وتجدد الاهتمام بها مع دخول الحوسبةComputerization في العديد من الصناعات وظهور مجموعات البيانات الكبيرة. وهذا هو ما ألهم تطوير تقنيات تعلم آلي أقوى، خصوصاً النُسخ الجديدة من التقنية المعروفة بالشبكة العصبية الاصطناعية Artificial Neural Networks. وبحلول التسعينات، فقد تمكنت الشبكات العصبية من رقمنة Digitize الحروف المكتوبة بخط اليد تلقائياً.

غير أن الشبكات العصبية الكبيرة جدا، أو “العميقة” Deep، لم تُظهر تحسنات هائلة في الإدراك الآلي Automated Perception إلا في بداية هذا العقد، وبعد عدة تعديلات و تنقيحات ذكية. فالتعلم العميق Deep learning هو المسؤول عن الثورة التي نشهدها اليوم في ميدان الذكاء الاصطناعي، إذ أعطى أجهزة الحاسوب قدرات استثنائية، مثل القدرة على التعرف على الكلمات المنطوقة تقريباً بنفس كفاءة أي شخص، وهي مهارة معقدة جداً ويصعب برمجتها يدوياً. كما أن التعلم العميق غيَّر رؤية الحاسوب وحسَّن الترجمة الآلية كثيراً. وهي تستخدم اليوم في توجيه مختلف أنواع القرارات المهمة في مجالات الطب والتمويل والتصنيع وغيرها.

كيفية عمل أي تقنية من تقنيات التعلم الآلي أكثرُ غموضاً من طريقة عمل نظام مُبرمج يدوياً، حتى بالنسبة إلى علماء الحاسوب. وهذا لا يعني أن جميع تقنيات الذكاء الاصطناعي في المستقبل ستكون مثلها غامضة، لكن تقنية التعلم العميق، من حيث طبيعتها، هي صندوق أسود معتم بالأخص.

لا يمكنك النظر داخل شبكة عصبية عميقة لترى كيفية عملها، فطريقة تفكيرها مدمجةٌ في سلوك آلاف الخلايا العصبية المماثلة لها، والمرتَّبة في عشرات أو حتى مئات الطبقات المتشابكة تشابكاً معقداً. وتتلقى الخلايا العصبية في الطبقة الأولى مدخلات Input، مثل كثافة البكسلات Pixels في صورة ما، ثم تُجري عملية حسابية قبل إنتاج إشارة جديدة. بعدها، ترسل هذه المُخرَجات Outputs وفق شبكة معقدة، إلى الطبقة التالية، إلى أن نحصل على المخرج النهائي. وإضافةً إلى هذا، هناك عملية تعرف بالانتشار الخلفي Back-propagation تُعدِّل حسابات الخلايا العصبية الفردية بطريقةٍ تتيح للشبكة تعلم إنتاج المخرَج المطلوب.

وتمكن الطبقاتُ العديدة الشبكةَ العميقة من معرفة الأشياء على مستويات مختلفة من التجريد. فعلى سبيل المثال، في نظام مصمم للتعرف على الكلاب، تعمل الطبقات السفلى على التعرف على أمور بسيطة مثل الخطوط العريضة للشكل واللون، أما الطبقات الأعلى فتتعرف على أشياء أكثر تعقيداً مثل الفراء والعينين، في حين تحدِّد الطبقة العليا الشيء كله على أنَّه كلب. ويمكن تطبيق المقاربة نفسها تقريباً على المدخلات التي تقود الآلة لتعليم نفسها: الأصوات التي تشكل الكلمات في الحديث، أو الحروف والكلمات التي تكوِّن الجمل في نص ما، أو حركات عجلة القيادة اللازمة لقيادة السيارة.

وقد استُخدمت استراتيجيات مبتكرة في محاولة تحديد ما يحدث داخل هذه النظم، ومن ثم شرحه بمزيد من التفصيل. ففي عام 2015، عدّل باحثون في غوغل خوارزمية التعرف على الصور، المعتمدة على التعلم العميق، بحيث تولِّد الصور أو تعدِّلها بدلاً من رصد الأجسام فيها. ومن خلال تشغيل الخوارزمية بفاعلية في الاتجاه المعاكس، أمكنهم اكتشاف السِّمات التي يستخدمها البرنامج للتعرف مثلاً على طائر أو بناء. أظهرت الصور النهائية، التي أنتجها مشروع الحلم العميق Deep Dream، حيواناتٍ بشعة شبيهة بالحيوانات الغريبة تبرز من بين الغيوم والنباتات، ومعابد بوذية منتشرة عبر الغابات وسلاسل الجبال. وأثبتت الصور أن التعلم العميق لا يتطلب الغموض التام، كما كشفت أن هذه الخوارزميات تعتمد على خواصَّ بصرية مألوفة مثل مناقير الطيور أو الريش، لكنها ألمحت أيضاً إلى الاختلاف الموجود بين التعلم العميق والإدراك البشري، من حيث إن هذه التقنية قد تجد معنىً في شيءٍ يظهر بالصورة، في حين نعرفَ نحن أن علينا تجاهله. ولاحظ الباحثون أن الخوارزمية عندما ولدت صوراً لأثقال التمرين، ولدت أيضا ذراعاً تمسكها، إذ خلُصت الآلة إلى أن الذراع جزء من الثقل نفسه.

لقد أحرز العلماء مزيداً من التقدم باستخدام أفكار مستعارة من علم الأعصاب والعلوم المعرفية ئognitive science. واستخدم فريقٌ بقيادة جيف كلون Jeff Clune، الأستاذ المساعد من جامعة وايومنغ University of Wayoming، النظير المقابل للأوهام البصرية في ميدان الذكاء الاصطناعي لاختبار الشبكات العصبية العميقة. وفي عام 2015، أظهرت مجموعة كلون البحثية كيف يمكن لبعض الصور أن تخدع هذه الشبكة وتجعلها تدرك أشياء لا وجود لها، لأن الصور تستغل الأنماط منخفضة المستوى التي يبحث عنها النظام. أيضاً، بنى جيسون يوسينسكي Jason Yosinski، أحد معاوني كلون، أداةً تعمل مثل مسبار داخل دماغٍ بشري، تستهدف الخلايا العصبية وسط الشبكة ثم تبحث عن الصورة التي تنشطها أكثر من غيرها. وظهرت الصور النهائية تجريدية (تخيل لوحة طائر النحام (فلامنغو) أو حافلة مدرسية مرسومة بريشة رسام انطباعي)، وهو ما يسلط الضوء على الطبيعة الغامضة لقدرات الآلة الإدراكية.

لكننا نحتاج إلى أكثر من لمحة عن كيفية تفكير الذكاء الاصطناعي، ولا يوجد حل سهل. فالتأثير المتبادل بين الحسابات داخل الشبكة العصبية العميقة هو العنصر الحاسم في التعرف على الأنماط عالية المستوى واتخاذ القرارات المعقدة، لكن هذه الحسابات تخلق مستنقعاً من الدوال الرياضياتية Mathematical functions والمتغيرات. ويقول جاكولا: “إذا كانت لديك شبكة عصبية صغيرة جداً، فقد تقدر على فهمها. لكن بمجرد أن تصبح الشبكة كبيرة جداً، وتكون لها آلاف الوحدات في كل طبقة، وربما مئات من الطبقات، فإنها تصبح غير مفهومة إلى درجة كبيرة.”

في المكتب المجاور لمكتب جاكولا توجد ريجينا بارزيلاي Regina Barzilay، الأستاذة بمعهد ماساتشوستس للتكنولوجيا (المعهدMIT)، والتي تعتزم تطبيق تعلم الآلة في الطب. فقد شُخّصت إصابة ريجينا بسرطان الثدي قبل عامين، في سن الثالثة والأربعين، كان ذلك صادماً في حد ذاته، لكنها صُدِمت أيضاً لغياب استخدام أحدث الوسائل الإحصائية وتقنيات التعلم الآلي للمساعدة في أبحاث الأورام أو توجيه علاج المرضى. تقول ريجينا إن الذكاء الاصطناعي لديه إمكانية هائلة لإحداث ثورة في الطب، لكن تحقيق هذه الإمكانية سيعني تجاوز السجلات الطبية، وتتطلع إلى استخدام المزيد من البيانات الخام التي تقول إنها غير مستعملة حاليا مثل: بيانات التصوير التشخيصي، وبيانات علم الأمراض، وكل هذه المعلومات.

وبعد إتمامها علاج السرطان في العام الماضي، بدأت ريجينا وطلبتها العمل مع الأطباء في مستشفى ماساتشوستس العام Massachusetts General Hospital؛ من أجل تطوير نظام قادر على التنقيب في التقارير المرضية بهدف تحديد الأشخاص الذين يحملون خصائص إكلينيكية محددة قد يرغب الباحثون في دراستها. ومع ذلك، فقد فهمت ريجينا أن النظام سوف يحتاج إلى شرح منطقه، لذا أضافت، بمعاونة جاكولا وأحد طلبتها، خطوة أخرى يستخرج فيها النظام مقتطفات نصية تتماشى مع النمط الذي اكتشفه ويعرضها.

وتطوِّر ريجينا بارزيلاي وطلبتها أيضاً خوارزميةَ تعلمٍ عميقٍ قادرة على إيجاد علامات مبكرة لسرطان الثدي في صور الثدي الشعاعية Mammogram images، بهدف منح هذا النظام القدرة على شرح استنتاجاته أيضاً. تقول ريجينا: “نحن بحاجة إلى امتلاك حلقة تُمكِّن الآلة والبشر من التعاون.”

ويستثمر الجيش الأمريكي بلايين الدولارات في مشروعات تستخدم التعلم الآلي في قيادة المركبات والطائرات وتحديد الأهداف ومساعدة المحللين على البحث في أكوام ضخمة من البيانات الاستخباراتية. وفي هذا الميدان، وأكثر من أي ميدان آخر، حتى المجال الطبي، لا يوجد مجال لغموض الخوارزميات، وقد اعتبرت وزارة الدفاع غياب قابلية التفسير عقبة رئيسية في وجهها.

ويشرف ديفيد غانينغ David Gunning، مدير البرامج في وكالة مشاريع الأبحاث المتقدمة للدفاع (اختصارا: الوكالة DARPA)، على برنامج الذكاء الاصطناعي القابل للتفسير Explainable Artificial Intelligence. يقول غانينغ، أحد الخبراء المتمرسين في الوكالة، الذي سبق له أن أشرف على مشروع الوكالة DARPA الذي قاد إلى إنشاء المُساعدة الذكية سيري Siri، إن الأتمتة دخلت مجالات لا تحصى في الجيش. ويختبر محللو المعلومات الاستخبارية تعلم الآلة كوسيلة لتحديد الأنماط داخل كميات هائلة من بيانات المراقبة، ويجري تطوير العديد من المركبات والطائرات ذاتية القيادة واختبارها، لكن الجنود ربما لن يشعروا بالارتياح داخل دبابة آلية لا تفسر عملها لهم، كما أن المحللين سوف يترددون في اتخاذ قرارٍ بناء على معلومات لا سندَ منطقياً لها. ويضيف غانينغ: “غالباً ما تنتج أنظمة التعلم الآلي كثيراً من الإنذارات الكاذبة، لأن هذا في طبيعتها، لذلك يحتاج محللو المعلومات الاستخبارية إلى مساعدة إضافية لفهم سبب توصيتها بأمر دون آخر.”

وفي مارس الماضي اختارت الوكالة DARPA تمويل 13 مشروعاً من الأوساط الأكاديمية والصناعية في إطار برنامج غانينغ. وبعض هذه المشروعات يمكن أن يُبنى على أعمال كارلوس غويسترين Carlos Guestrin، الأستاذ من جامعة واشنطن، إذ وضع هو وزملاؤه طريقة تمكّن أنظمة التعلم الآلي من توفير أساس منطقي لمخرجاتها.

باستخدام هذه الطريقة، يجد الحاسوب، تلقائياً، أمثلة قليلة من مجموعة بيانات معينة ويقدمها في شرحٍ قصير يفسر عمله. فعلى سبيل المثال، يمكن أن يستخدم نظامٌ مصمم لتصنيف رسائل البريد الإلكتروني المرسَلة من إرهابيين ملايينَ الرسائل في مرحلة التدريب وصنع القرار، لكن باستخدام الطريقة التي توصل إليها فريق واشنطن البحثي، يمكن للنظام أن يبرز بعض الكلمات الرئيسية الموجودة في رسالةٍ من تلك الرسائل. وقد صممت مجموعة غويسترين أيضاً طرقاً تمكِّن نظم التعرف على الصور من الإشارة إلى كيفية تفكيرها عن طريق إبرازها أجزاء الصورة التي تعتبر أكثر أهمية. وأحد عيوب هذه الطريقة وطرق أخرى مشابهة، مثل طريقة ريجينا، هو أن التفسيرات المقدمة تكون دائماً مبسطة، وهذا يعني ضياع بعض المعلومات الأساسية على طول الطريق. ويقول غويستيرين: “لم نحقق الحلم كله، الذي يكون فيه الذكاء الاصطناعي قادراً على تبادل الحديث معنا وشرح أفعاله. فأمامنا مشوار طويل قبل الوصول إلى ذكاء اصطناعي قادر على تفسير سلوكه.”

لا يقتضي الأمر حالات عالية المخاطر مثل تشخيص السرطان أو المناورات العسكرية كي يخلق غياب التفسير مشكلات، فمعرفة كيفية تفكير الذكاء الاصطناعي سيكون حاسماً أيضا إذا أردنا أن تصبح هذه التكنولوجيا جزءاً شائعاً ومفيداً من حياتنا اليومية. يقول توم غروبر Tom Gruber الذي يقود فريق سيري في شركة آبل إن قابلية التفسير هي أحد الاعتبارات الرئيسية لفريقه في أثناء محاولتهم جعل سيري مساعدة افتراضية أكثر ذكاءً وكفاءة. ولم يناقش غروبر خططاً محددة لمستقبل سيري، لكن من السهل تخيل أنك حين تتلقى توصية لأحد المطاعم من سيري، سوف تريد معرفة المنطق وراء هذه التوصية. ويرى رسلان سالاخوتدينوف Ruslan Salakhutdinov، مدير أبحاث الذكاء الاصطناعي في شركة آبل والأستاذ المشارك من جامعة كارنيغي ميلون Carnegie Mellon University، أن قابلية التفسير توجد في صميم العلاقة المتطورة بين البشر والآلات الذكية، مضيفاً أنها “ستولد الثقة بين الطرفين.”

وكما يستحيل تفسير جوانب عدة من السلوك البشري بالتفصيل، فمن غير المحتمل أن يكون في مقدور الذكاء الاصطناعي شرح أفعاله كلها. ويقول كلون، الأستاذ بجامعة وايومنغ: “وحتى لو كان بإمكان شخص ما أن يقدم لك تفسيراً معقولاً لأفعاله، فإنه ربما يكون تفسيراً غير كامل، والشيء نفسه قد يكون صحيحاً فيما يخص الذكاء الاصطناعي،” ويضيف قائلا: “قد تكون خاصية تميز طبيعة الذكاء أن جزءاً منه فقط يمكن إخضاعه للتفسير العقلاني، أما الأجزاء الأخرى فبعضها إما غريزيٌ، أو غيرُ واعٍ، أو غامضٌ.”

إذا كان هذا صحيحاً، ففي مرحلة ما قد نضطر ببساطة إلى الثقة بحكم الذكاء الاصطناعي أو الاستغناء عن استخدامه. كذلك، يجب أن يدخل الذكاء الاجتماعي Social intelligence عند اتخاذ هذا الحكم. فكما أن المجتمع مبني على عقد اجتماعي من السلوك المتوقع، نحن بحاجة إلى تصميم أنظمة ذكاء اصطناعي تحترم وتقبل معاييرنا الاجتماعية. وإذا أردنا إنشاء دبابات آلية وآلات قتل أخرى، فمن المهم أن تكون قراراتها متسقة مع أحكامنا الأخلاقية Ethical judgments.

تقصياً لهذه المفاهيم الميتافيزيقية، ذهبت إلى جامعة تافتس Tufts University للقاء دانيال دينيت Daniel Dennett، الفيلسوف الشهير والمتخصص في العلوم المعرفية الذي يدرس الوعي والعقل. يوشير فصل من كتاب دينيت الأخير، من البكتيريا إلى باخ ذهابا وإياباFrom Bacteria to Bach and Back الكتاب الموسوعي عن الوعي، إلى أن جانباً طبيعياً من تطور الذكاء نفسه هو إنشاء أنظمة قادرة على أداء مهام لا يعرف صانعوها كيفية القيام بها. يقول لي داخل مكتبه في حرم الجامعة: “السؤال هو: ما التسهيلات التي يجب أن نقدمها للقيام بذلك بحكمة؟ وما المعايير التي نطالب بها الذكاء الاصطناعي، وأنفسنا أيضاً؟”

لديه أيضاً كلمة تحذيرية حول السعي إلى تحقيق قابلية التفسير، إذ يقول: “أظنُ أننا إذا كنَّا سنستخدم هذه الأشياء ونعتمد عليها، فبلا شك ينبغي أن نُحكم قبضتنا قدر الإمكان على كيفية تقديمها للأجوبة وسبب ذلك.”

لذلك، نظراً لعدم توفر إجابة كاملة، فيجب أن نكون حذرين من التفسيرات التي يقدمها الذكاء الاصطناعي مثلما نحترس من الشروحات التي نقدمها لبعضنا، مهما بدت الآلة ذكية. ويضيف دينيت: “إذا كانت الآلة ليست أفضل منَّا في تقديم تفسيرات تشرح سلوكها، فلا تثقوا بها.”