نحو برمجة الإنسالة

نحو برمجة الإنسالة

ليكون سلوكها سليما(*)

يوشك أن يكون للآلات المستقلة بذاتها(1) دور رئيسي

في حياتنا. وقد آنَ لها أن تتعلَّم آدابَ السلوك السليم.

<M.أندرسون> – <L.S.أندرسون>

في مَشاهد قصص الخيال العلمي الكلاسيكية المرعبة، تغدو الآلاتُ على قدر كاف من الذكاء تتحدّى به البشر، وليس لديها من الحرج الأخلاقيِّ ما يردعها عن إيذائنا، بل ربما تدميرنا. ولئن كانت الإنسالاتُ اليومَ بطبيعة الحال تُستحدَث وتُطَوَّر لتكون عونا للإنسان، فقد تبيَّنَ أنها تواجِه جملة من الإشكالات الأخلاقية التي من شأنها أن توسِّع حدودَ الذكاء الصُّنعي(2)، حتى في الأحوال والظروف المعتادة.

| باختصار

ثمة إنسالات(3) يمكنها اتخاذُ قرارات مستقلة، كتلك التي تصمَّم لمساعدة المسنِّين. وقد تواجِه هذه الإنسالاتُ خيارات أخلاقية صعبة، حتى فيما يبدو أنها مواقف من الحياة اليومية. ومن الطرائق التي تضمن للإنسالات التي تتفاعل مع البشر أن تلتزم باتباع سلوك أخلاقي سليم، هي برمجةُ جملة من المبادئ الأخلاقية العامة تُدْخَل في تصميمها، فتتيح لها اتباع تلك المبادئ في اتخاذ قراراتها وفقا لمقتضيات كلِّ حالة. وبإمكان تقنياتِ الذكاء الصُّنعي توليد هذه المبادئ باستخلاصها من وقائع محدَّدة من السلوك المقبول أخلاقيا باستعمال المنطق. وهنا يتَّبع المؤلِّفان هذه المقاربة على نحو غير مسبوق، لبرمجة أفعال إنسالة تستند في سلوكها إلى مبادىء أخلاقية. |

تخيَّلْ أنك نزيلُ دار للمسنِّين(4) – تلك الأوساط التي ربما ستصبح فيها الإنسالاتُ عمّا قريب أمرا مألوفا وشائعا. وفي صباح أحد الأيام كانت الساعة تقترب من الحادية عشرة عندما طَلَبتَ إلى مساعد الإنسالة في غرفة الجلوس المشتركة إحضارَ أداة التحكُّم من بُعد كي تدير التلفاز لمشاهدة البرنامج الذي يحمل اسم The View. غير أن نزيلة أخرى تطلب في الوقت نفسه أداةَ التحكُّم لأنها ترغب في مشاهدة البرنامج المعنون The Price Is Right. فالإنسالةُ تقرِّر تسليمَ أداة التحكُّم إليها، فتشعر أنت بالامتعاض أولَ وهلة، قبل أن تقدِّم الإنسالةُ مسوِّغا لسلامة قرارها يتمثَّل بأنك انصرفتَ لمتابعة برنامجك الصباحيِّ المفضَّل في اليوم السابق. وفي حين تمثِّل هذه الطرفةُ أنموذجا معتادا لواقعة اتِّخاذ قرار أخلاقي، فإنها تُعَدُّ بالنسبة إلى الآلة إنجازا شاقا عسيرَ التنفيذ إلى حدّ بعيد.

وما زال المشهدُ الذي أوردناه آنفا حَدَثا نظريّا محضا، غير أننا قدَّمنا أولَ عرض لإنسالة قادرة على اتخاذ قرارات مشابهة؛ فزوَّدْنا آلتَنا بمبدأ أخلاقي تستعمله لتحديد عدد المرات التي يتعيَّن عليها تذكير مريض بتناوُل دوائه. وقد أثبتت برمجةُ إنسالتنا حتى الآن قدرتَها على الاختيار من بين بضعة خيارات ممكنة، كالمداومة على تذكير المريض مرة بعد مرة بتعاطي الدواء، وتعيين موعد تناوله، أو مجاراة قرار المريض عدمَ تناوله. وهذه الإنسالة كما نعلم، هي الأولى في نوعها من حيث اعتمادها على مبدأ أخلاقي في تقرير أفعالها.

|

| ناو Nao، أول إنسالة تُبرمَج وفقَ مبدأ أخلاقي، صنّعتها شركة الديباران للإنساليات. |

ولا شك في أنه من الصعب جدا، إن لم يكن من المستحيل، توقُّع كلِّ قرار قد تواجهه الإنسالة وبَرْمَجَته على نحو يحملها على التصرُّف على الوجه المرغوب في كلِّ موقف يمكن أن يخطر في البال. ومن ناحية أخرى، فإن منعَ الإنسالات من القيام بأيِّ فعل قد يثير مخاوفَ أخلاقية حَرِيٌّ بأن يَحُدَّ – بلا داع – من فُرَصِ الإنسالات لأداء أعمال من شأنها رفع مستوى حياة الإنسان بدرجة كبيرة. ونعتقد أن الحلَّ يكمن في تصميم إنسالات قادرة على تطبيق مبادئ أخلاقية في مواقف جديدة وغير متوقَّعة، كي تقرِّر مثلا مَنْ هو الشخص الذي يمكنه أن يقرأ كتابا جديدا، بدلا من أن تقرِّر مَنْ هو الشخص التالي المخوَّل حيازةَ جهاز التحكُّم. على أن لهذه المقاربة فائدة أخرى وهي تمكين الإنسالات من العودة إلى تلك المبادئ إذا ما طُلِبَ إليها تسويغُ تصرُّفاتها؛ وهذا مطلبٌ أساسيٌّ لراحة الإنسان في سياق تفاعُلِه معها. ومن ثم، فإن الجهود المبذولة لتصميم إنسالات أخلاقية قد تفضي كذلك إلى إحراز تقدُّم في ميدان الأخلاق ذاتها، عن طريق دفع رجال الفكر والفلسفة إلى استقصاء ظروف من واقع الحياة، أوجزَها منذ عهد قريب الفيلسوف <C.D.دينيت> [من جامعة تافْتس] بقوله: «إن الذكاء الصُّنعيَّ يجعل من الفلسفة عِلما قويم الأخلاق.»

أنا، إنسالة(**)

وأغلب الظن أن الإنسالاتِ المستقلَّةَ ذاتيّا(5) لن تلبث أن تكون جزءا من حياتنا اليومية. فبعضُ الطائرات أضحت بالفعل قادرة على الطيران ذاتيا، والسياراتُ الذاتيةُ القيادة بات ظهورُها قريبا. بل إن ما تُسمى «البيوت الذكية»smart homes، التي تتحكَّم الحواسيبُ في إدارة كلِّ ما فيها من أمور الإضاءة إلى التيار الكهربائي المتناوب، يمكن النظرُ إليها على أنها إنسالاتٌ يمثِّل جسمُها البيتَ برمَّته – تماما كما كان الحاسوب HAL 9000، الذي وظَّفَه المخرج <S.كوبريك>(6) في فيلمه المتميِّز 2001: A Space Odyssey، يجسِّد القدرةَ العقليةَ لمركبة فضائية إنسالية. ومن ثم، فإن هناك عددا من الشركات اليوم تتولى تطويرَ إنسالات قادرة على مساعدة الأشخاص المسنِّين على أداء أعمالهم اليومية، إما رفدا للكادر البشري العامل في دار للمسنِّين، وإما لتمكين المسنِّين من الأخذ بأسباب العيش في بيوتهم بأنفسهم. ومع أن معظم هذه الإنسالات ليس من شأنها اتِّخاذ قرارات مصيرية، فإن ما يجعل وجودَها مستحسَـنا بيننا هو أن تكون تصرُّفاتُها في نظرنا مقبولة أو سليمة أو على الأقل وديعة. وعندئذ، يجدر بمخترعيها أن يأخذوا في حسبانهم التداعياتِ السلوكيةَ في برمجتها.

فإذا سلَّمنا بأن تضمين مبادئ الأخلاق في الآلات المستقلَّة ذاتيّا هو مفتاح نجاحها في التآثر مع البشر، فإن أول سؤال يفرض نفسه هو: أيُّ المبادئ يتعيَّن اعتماده في تلك الآلات؟ ربما يعتقد أنصارُ أدب الخيال العلمي أن الجوابَ ما قدَّمه <I.أَزيموڤ> منذ زمن في إطار قوانينه الثلاثة المبتكَرة في الإنساليات:

1. ألاَّ تؤذي الإنسالةُ أحدا من البشر، أو أن تتسبَّب – بحكم عطالتها – في إيذاء أحد.

2. أن تمتثل الإنسالةُ لأوامرَ الإنسان، ما لم تتعارض تلك الأوامر والقانون الأول(7).

3. أن تحمي الإنسالةُ وجودها ما دامت هذه الحمايةُ لا تتعارض والقانون الأول أو القانون الثاني.

ولكن البعضَ اكتشف مَواطنَ تَناقُض لدى التعمُّق في مضامين هذين القانونين، التي أوردها <أزيموڤ> أولَ ما أوردها في قصة قصيرة سنة 1942، ثم أقرَّ هو نفسُه بعدم جدواها في قصة له بعنوان “The Bicentennial Man(1976)»، حيث يوجِّه فيها بعضُ المشاغبين من الناس أمرا إلى إنسالة بأن تفكِّك نفسَها. وكان على الإنسالة أن تمتثل لأمرهم طبقا للقانون الثاني، ولم يكن في وسعها الدفاع عن نفسها من دون إلحاق الأذى بهم، خارقة بذلك القانونَ الأول.

وإذا كان قانونا <أزيموڤ> غيرَ مقبولين، فما هو البديل؟ بل هل يمكن أن يوجدَ بديلٌ أصلا؟ يذهب بعضُ الناس إلى الاعتقاد أن تطبيق السلوك الأخلاقي في الآلات الصمَّاء هو بحدِّ ذاته افتراضٌ عقيم. فالأخلاق، كما يقولون، ليست بالأمر القابل للحوسبة، ومن ثم فمن المستحيل برمجتُها داخل آلة. ومع ذلك، فقد رأى المفكِّران الإنكليزيان <J.بنثام> و<S.J.ميل> من قبلُ (في القرن التاسع عشر) أن اتِّخاذَ قرار أخلاقي هو مسألة إجراء «عملية حسابية افتراضية»، مستندَيْن إلى مذهبهما في النفع للصالح العام(8)، الذي صيغَ في مقابل نظام أخلاقيّ قائم على مبدأ الحدس الذاتي subjective intuition، الذي يرى أن الفعل القويم هو ذلك الفعل الذي من شأنه أن يحقِّق أعظمَ قدر من «السعادة المحضة» التي يمكن حسابُها عن طريق جمع وحدات السرور وطرح وحدات الكدر، مما عاناه جميعُ المعنيِّين ذوي الصِّلة. ويشكك معظمُ المختصِّين بالأخلاق السلوكية في أن تكون هذه النظريةُ قادرة على تعليل جميع جوانب القضية الأخلاقية؛ فهي تعاني مثلا قصورا في الأخذ بالاعتبار جميع النواحي المتعلقة بالعدالة، ولربما تفضي إلى التضحية بمصالح الفرد في سبيل مصالح غالبية الأفراد. ولكنها تُظهِر على الأقل أنَّ أية نظرية أخلاقية معقولة لأول وهلة هي – من حيث المبدأ – نظريةٌ قابلةٌ للحوسبة(9).

في حين يشكِّك آخرون في قدرة الآلات أصلا على صُنع قرارات أخلاقية، وذلك بالنظر إلى أنها تفتقر إلى الانفعالات والأحاسيس، ومن ثمَّ فهي لا تستطيع أن تعيَ مشاعرَ جميع الأفراد المعنيِّين بتبعات تصرُّفاتها أو أن تقدِّر بواعثَهم حقَّ التقدير. ولمّا كان الإنسانُ بطبيعته ينساق بالانفعالات، فإنه كثيرا ما ينتهي إلى التصرُّف على نحو لا يتَّفق مع الأخلاقيات السلوكية الرصينة. ومن شأن هذه الخاصيَّة لدينا، إضافة إلى نزوعنا الفطريِّ إلى محاباة أنفسنا ومَنْ يلوذ بنا من أقربائنا وأعزائنا الأدنين، ألاّ تجعلنا في الغالب الأعمِّ صُنَّاعا مثاليِّين لقرار أخلاقيّ قويم. وفي اعتقادنا أنه بالإمكان تصميم آلة تُعَدُّ إعدادا حسنا لتكون حيادية في استجابتها للانفعالات الإنسانية وأخذها لها في حساباتها، وإن كانت هي نفسُها خِلْوا من الانفعالات.

|

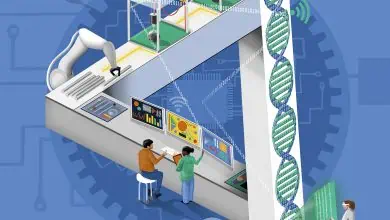

أول إنسالة أخلاقية تكويد قواعد السلوك(***) كثيرا ما يتعيَّن على الإنسالات التي تتآثر مع البشر أن تتَّخذ قرارات لها تداعيات أخلاقية. وليس في وسع المبرمجين التنبُّؤ بكل إشكال أخلاقي قد يعترض الآلة، غير أن بإمكانهم توفير مبدأ شامل (في الأسفل) قادر على توجيه اتخاذ القرار عن كل واقعة على حدة (في اليمين). وقد عرضَ المؤلِّفان هذه المنهجية عن طريق برمجة إنسالتهم المسمّاة «ناو» (انظر أعلاه) لتقرير مدى ضرورة تذكير مريض بتناول دوائه وتوقيت ذلك.

وضع القواعد يستطيع المصمِّمون برمجةَ الإنسالات بمبدأ أخلاقي يُستنبَط بتطبيق تقنية في الذكاء الصُنعي تُدعى «التعلُّم الآلي» machinelearning. يلقِّم المصمِّمون خوارزميةَ التعلُّم الآلي بمعلومات عن الخيارات التي ينبغي اعتبارُها سليمة أخلاقيا في عدد من الحالات المختارة، اعتمادا على معايير مثل: مدى الفائدة المرجوَّة من فعل ما، ومدى الضرر إذا لم ينفذ، ومدى الحيادية في اتخاذ القرار. ومن ثم، تَستخلِص الخوارزميةُ مبدأ عاما يمكن تطبيقُه على حالات جديدة.

قرارات، قرارات تستطيع إنسالةٌ تساعد المسنِّين أن ترتِّب أولويات خِدماتها المحتملة وفقا لدرجة تلبية هذه الخدمات للمعايير الأخلاقية. واعتمادا على تلك التقديرات تَستعمِل مبدأَها المدمَج فيها لتحديد أولويات أعمالها في وقت معيَّن. فعلى سبيل المثال، إذا طلبَ أحدُ النزلاء طعاما وطلبَ آخرُ جهازَ التحكُّم التلفزيوني، فلربما تجد الإنسالةُ أن من المصلحة أداءَ عمل آخر أولا، كتذكير مريض بتناوُل دوائه. |

تعلُّمٌ بالمثال(****)

وبافتراض أن بالإمكان فعلا تلقين الإنسالات قواعدَ أخلاقية، فممن ينبغي أن تؤخذ هذه القواعد؟ إن علينا ألا ننسى أولا أن أحدا لم يتمكن حتى اليوم من تقديم مجموعة عامة من المبادئ الأخلاقية لبني البشر مقبولة بلا استثناء. أما الآلات، فإنها تُصنَع عادة للعمل ضمن مجالات معيَّنة ومحدودة. وفي حالات كهذه تكون مهمةُ تحديد المعايير الأخلاقية للسلوك أخفَّ وطأة من محاولة صوغ قواعد شاملة للسلوك الأخلاقي واللاأخلاقي، وهذا تماما ما يحاول واضعو نظريات الأخلاق فعله. كذلك، فعندما يُطرح على المختصِّين بالأخلاقيات السلوكية توصيفٌ لحالة معيَّنة في إطار سياقات عديدة يمكن أن تعمل فيها الإنسالات، فإنهم يتَّفقون على ما هو جائزٌ سلوكيّا وما هو غير جائز. (ونحن نرى أنه في الحالات التي لا يَتوَصَّل فيها المختصُّون إلى اتفاق، يجب ألا يُسمح للآلات بأن تَتَّخذ قرارات ذاتية على الإطلاق.)

|

لحظات مشهودة في أخلاقيات آلة عندما يقلد العلمُ الفنَّ(*****) قبل زمن طويل من التفات خبراء الأخلاق والإنسالياتِ والذكاءِ الصُّنعي إلى الاهتمام بالتداعيات الأخلاقية المحتملة لسلوك الإنسالات، كانت تراود مخيِّلةَ كُتَّاب قصص الخيال العلمي ومخرجي الأفلام أفكارٌ عن تصوُّرات لم تكن دائما بعيدة عن الواقع. على أن أخلاقيات آلة غدت، في غضون السنوات القريبة الماضية، ميدانا حقيقيّا للبحث، يستمد الإلهامَ – في جزء منه – من كتابات فلاسفة القرن الثامن عشر.

|

وقد اقترح الباحثون عددا من المقاربات المختلفة لاستنباط قواعدَ للسلوك الآلي، وغالبا ما كان ذلك باستعمال تقنيات الذكاء الصُّنعي. ففي سنة 2005، على سبيل المثال، قدَّم <R.رزيپكا> و<K.أراكي> [من جامعة هوكايدو في اليابان] «خوارزميات معتمِدة على الديمقراطية»، تقوم بمسح شبكة الوِبْ بحثا عن معلومات ذات صلة بما كان يعدُّه الناسُ فيما مضى أفعالا مقبولة من الناحية الأخلاقية، ثم تَستعمل التحليلَ الإحصائيَّ لاستخلاص إجابات عن أسئلة جديدة. وفي سنة 2006، رأى <M.گواريني> [من جامعة ويندسور في أونتاريو] أن الشبكات العصبونية(10) neural networks – وهي خوارزميات يستلهمها الدماغُ البشري، وتتعلَّم معالجةَ المعلومات بطريقة أمثلية(11) أكثر فأكثر – يمكن «تدريبها»، عن طريق الاستعانة بحالات راهنة، على تعرُّف واختيار القرارات المقبولة أخلاقيا في حالات مشابهة.

وفي رأينا، الذي يعكسه بحثُنا أن اتخاذَ قرار أخلاقي يقتضي الموازنة بين التزامات عدة، يسمِّيها المختصُّون بالسلوكيات «الواجباتِ الصحيحةَ لأول وهلة»(12)؛ وهي واجباتٌ، وإن كان علينا التزامُها أساسا، قد نُضطَرُّ أحيانا إلى تجاوُز بعضها على حساب بعضها الآخر. فلئن كان من واجب المرء مثلا التزام وعوده عموما، فلا بأس – في سبيل درء خطر جسيم – من نقض وعد بسيط لا يترتَّب على نقضه تبعةٌ ذاتُ بال. وإذا تعارضت الواجباتُ جازَ أن تكون المبادئُ الأخلاقية هي الفيصل في تحديد الواجب الذي ينبغي أن تكون له الأولويةُ في كلِّ موقف.

وللحصول على المبادئ الأخلاقية التي يمكن برمجتُها في إنسالة، فإننا نستعمل تقنيةَ ذكاء صُنعيّ تُدعى تقنية «التعلُّم الآلي» machine learning. وبمقتضاها تَنْفُذ خوارزميتنا إلى عدد نموذجيّ من الحالات الخاصة التي حدَّدَ فيها الإنسانُ قرارات بعينها على أنها صحيحةٌ من الناحية الأخلاقية. وإن هذه الخوارزمية تستعين بالمنطق الاستقرائي inductive logic لاستخلاص مبدأ أخلاقي. وتَحْدث مرحلةُ «التعلُّم» هذه عند تصميم البرمجيات، ومن ثمَّ يُدخَل المبدأُ السلوكيُّ الحاصلُ مكودا encoded في برمجة الإنسالة.

وكاختبار أول لطريقتنا، فقد دَرَسنا حالة يتعيَّن فيها على الإنسالة تذكير المريض بتناول دوائه وإشعار طرف ثالث مراقِب عندما لا يمتثل المريض. ويكون على الإنسالة الموازنة بين ثلاثة واجبات: التحقُّق من حصول المريض على فائدة مرجوَّة من تعاطي الدواء، والحيلولة دون وقوع ضرر قد ينجم عن الامتناع عن تناول الدواء، واحترام استقلالية رأي المريض (الذي يُفترض أن يكون راشدا ومؤهَّلا). ويُعَدُّ واجبُ احترام استقلالية المريض بصفة خاصة على رأس الأولويات في مضمار السلوكيات الطبيّة، علما بأن هذا الواجب بالذات يمكن خرقُه فيما لو أمعنت الإنسالة في تذكير المريض أكثر مما يلزم، أو أنها سارعت إلى إعلام الطرف المراقِب عاجلا بعدم امتثال المريض.

وقد لوحظَ، بعد تلقيم الآلة بمعلومات عن حالات خاصة، أن خوارزميةَ التعلُّم الآلي وَلَّدت المبدأَ الأخلاقي الآتي: يجوز لإنسالة الرعاية الصحيّة معارضة قرار المريض – أي خرق استقلالية رأيه – كلَّما عجزت التصرُّفاتُ الأخرى عن الحيلولة دون وقوع ضرر، أو تسبَّبَت في خرق صارخ لواجب تقديم مصلحة المريض.

فكرةٌ ذات أرجل(******)

ومن ثم، فإننا بَرْمجنا المبدأَ وجسَّدناه في إنسالة بلَبوس بشريّ أطلقنا عليها اسم «ناو» Nao، وهي من تصنيع الشركة الفرنسية Aldebaranللإنساليات. ومن خصائصها قدرتُها على تحديد مكان المريض والتوجُّه إليه لتذكيره بتناول الدواء، وإحضار الدواء له، ومخاطبته باستعمال اللغة الطبيعية(14)، وإشعار المراقِب عن طريق رسالة إلكترونية عند اللزوم. تتلقّى الإنسالةُ دخلا أوَّليّا initial input من قبل المراقِب (الذي يكون طبيبا في العادة) يشتمل على معلومات من مثل: مواعيد تناوُل الدواء، ومدى الضرر الأقصى المترتِّب على عدم تناول الدواء، ومقدار الزمن المستغرَق لوقوع هذا الضرر الأقصى، وحدود الفائدة القصوى المرجوَّة من تعاطي الدواء، ومدة الزمن المستغرَق قبل انتهاء هذه الفائدة. ومن هذا الدخل تَحسب الإنسالةُ مستوياتِها من الرضا عن حسن أداء كلّ من الواجبات الثلاثة أو خرقها، وتشرع في أداء أفعال مختلفة تبعا لما يطرأ على تلك المستويات من تغيُّرات مع مرور الوقت؛ فهي تُصْدِر تنبيها عند وصول مستويات الرضا عن أداء الواجبات أو خرقها إلى الدرجة التي يصبح فيها التذكيرُ – وفقا لمبدئها الأخلاقي – مقدَّما على عدم التذكير. وتجدر الإشارة هنا إلى أن الإنسالة لا تقوم بإشعار المراقِب إلا حينما يصل الأمرُ إلى درجة يصبح فيها المريضُ عُرضة لضرر محدق أو لضياع فائدة كبيرة، بسبب عدم تناوُله الدواء.

ولعلَّ النموذجَ المكتمِل من إنسالة أخلاقية لرعاية المسنِّين(15) (اختصارا: إثيل EthEl) يحتاج إلى مبدأ أخلاقي أكثر تعقيدا، يمكِّنه من استغراق جوانب سلوكه الأوسع نطاقا، علما بأن أسلوبَ التعاطي عموما يبقى واحدا على كل حال. وهنا تَستعمل الإنسالةُ ذلك المبدأَ في تنفيذ جولاتها في أرجاء دار المسنِّين، كي تحدِّد متى يكون لواجب معيَّن الأفضليةُ على واجب آخر. وفيما يلي عرضٌ لأحداث يوم نموذجي.

في الصباح الباكر تقف الإنسالة الأخلاقية إثيل في إحدى الزوايا، موصولة بقابس الطاقة الجداري. وما أن تُشحَن بطارياتها تماما حتى يهيمن واجبُها في تقديم المساعدة على واجبها في إصلاح نفسها، فتنطلق في أنحاء الغرفة لتفقد نزلاء الدار وعرض خدماتها المفيدة – كإحضار كأس من الشراب، ونقل رسالة إلى نزيل آخر، وهكذا. وفي أثناء تنفيذها للمهام، تسجِّل مستويات مبدئية للتوفيق في أداء كلِّ واجب يتَّصل بالمهمَّة المؤدّاة، أو خرقه. وعندما يَطلب إليها نزيلٌ موعوكٌ استدعاء ممرِّضة، فإن تجاهُلَها محنةَ النزيل يعني خرقَها لواجب الحيلولة دون وقوع الأذى، ومن ثم صار ذلك الواجبُ الآن مقدَّما على واجبها في فعل الخير، فهي لذلك تبادر إلى البحث عن ممرِّضة وإبلاغها بحاجة النزيل إلى خدماتها، ولدى إتمامها لهذه المهمة، تعود الإنسالةُ إلى سيرَتها الأولى في الاضطلاع بواجبها في تقديم المساعدة، مستأنفة جولاتِها التفقُّدية.

وعندما تدقُّ الساعة العاشرة صباحا، يكون الوقتُ قد حان لتذكير أحد النُّزلاء بتناوُل دوائه. ولمّا كان هذا العمل يفي بواجب تقديم المساعدة، فقد صار مقدَّما على كلِّ ما سواه؛ وهذا يستتبع أن تتَّجه الإنسالة الأخلاقية إثيل نحو ذلك النزيل وتعطيَه دواءه. وفي وقت لاحق يُرى النُّزلاءُ مستغرقين في مشاهدة برنامج تلفزيوني – وليكن The View أو The Price Is Right. فإذا وَجَدت الإنسالة الأخلاقية إثيل أن ليس ثمة واجباتٌ معلَّقةٌ تنتظر منها الأداء، وأنَّ طاقةَ بطارياتها أوشكت على النفاد، استشعرت عندئذ واجبَها تجاه نفسها، فعادت إلى زاوية الغرفة تجدِّد شحنَ بطارياتها.

وواقع الأمر أن مبحثَ أخلاق الآلة machine ethics لم يتخطَّ بعدُ عتبةَ البدايات. وما انتهينا إليه من نتائج، وإن كانت مبدئية وتمهيدية، يملأ نفوسَنا أملا بأن المبادئَ الأخلاقية التي تكتشفها آلة، يمكن استعمالها لتوجيه سلوك جملة الإنسالات وجعل مواقفها تجاه الإنسان أكثر قبولا. ولا ريب في أن غرسَ المبادئ الأخلاقية في الإنسالات أمرٌ بالغ الأهمية؛ ذلك أن الناس إذا خالَطَهم شعورٌ بأن الإنسالاتِ الذكيةَ ربما تتصرَّف على نحو لا ينسجم والسلوك القويم، فقد يصل بهم الأمرُ إلى نبذ الإنسالات المستقلة برمَّتها، ومن ثم قد يصبح مستقبلُ الذكاء الصُّنعي نفسه في مهبِّ الريح.

ومن الطريف أن أخلاق الآلة ربما تؤثِّر في نهاية المطاف في مبحث الأخلاق عموما، وقد تغدو الرؤيةُ «الواقعية» لأبحاث الذكاء الصنعي أقربَ إلى التقاط ما يُعَدُّ تصرُّفا سلوكيا أخلاقيا عند البشر منها إلى التنظير المجرَّد من قبل الأكاديميين الاختصاصين في الأخلاق. ومَنْ يدري، فقد تُرَوَّضُ الآلاتُ مسقبلا ترويضا يجعلها تتفوَّق في سلوكياتها على كثير من أخلاق بني البشر، وذلك بحكم ما سوف تتمتَّع به من قدرة على صُنع قرارات محايدة، وهي مزيَّةٌ لا يجيدها الناسُ كثيرا في جميع الأوقات. بل لعلَّ التآثرَ مع إنسالة أخلاقية سيكون في يوم من الأيام باعثا لنا على تهذيب سلوكنا

المؤلفان

| Michael Anderson – Susan Leigh Anderson | ||

| Michael Anderson

حائز على الدكتوراه من جامعة كونيتيكَتْ، وأستاذ مساعد في علم الحاسوب بجامعة هارتفورد. له اهتماماتٌ طويلة العهد بالذكاء الصُّنعي.

Susan Leigh Anderson حائزة على الدكتوراه من جامعة كاليفورنيا – لوس أنجلوس، وأستاذة فخرية بجامعة كونيتيكت في اختصاص الأخلاق التطبيقية. وفي عام 2005 أسهمت مع <M.أندرسون> في تنظيم الندوة الدولية الأولى أخلاقيات الآلة machine ethics. وسيصدر لهما قريبا كتابٌ في هذا الموضوع من مطبوعات جامعة كامبريدج. |

|

|

مراجع للاستزادة

IEEE Intelligent Systems. Special issue on machine ethics. July/August 2006. A Robot in Every Home. Bill Gates in Scientific American. VW. 296, No. I pages 44-51; January 2007.

Machine Ethics: Creating an Ethical Intelligent Agent Michael Anderson and Susan Leigh Anderson in At Magazine, Vol. 28, No. 4. pages 15-26; Winter 2007.

Moral Machines: Teaching Robots Right from Wrong. Colin Allen and Wendell Wallach. Oxford University Press, 2008.

War of the Machines. P. W. Singer in scientific American, vol. 303. No. 1. Pages 36-43; July 2010.

(*)ROBOT BE GOOD

(**)I, ROBOT: (من قصص الخيال العلمي للكاتب الأمريكي (الروسي المولد.

(***)Coding Rules of Behavior

(****)LEARNING BY EXAMPLE

(*****)When Science Imitates Art

(******)AN IDEA WITH LEGS : فكرة من المرجّح نجاحها أو استمرارها.

(1) Autonomous machines

(2) artificial intelligence AI: فرعٌ من علم الحاسوب يمكِّن الآلةَ من محاكاة بعض مظاهر الذكاء البشري مثل: تعرُّف الكلام والاستنتاج والاستجابة الخلاّقة والاستدلال من معلومات غير كاملة. من تطبيقاته العامة: النُّظُم الخبيرة ومعالجة اللغات الطبيعية.

(3) robots = إنسالات، ج: إنسالة، وهذه نَحْتٌ من إنسان ـ آلي robots ومنها نشتق: إنسالية = robotic: علم الإنسالات.

(4) assisted-living facility: منشأة سكنية خاصة بالمسنِّين (المتقاعدين مثلا)، ممَّن هم بحاجة إلى مساعدة جزئية فقط في أداء أعمالهم اليومية، غير أنهم ليسوا بحاجة إلى الرعاية الكاملة في دار العجزة.

(5) Autonomous Robots

(6) Stanley Kubrick: مخرج سينمائي أمريكي، تميَّزت أفلامُه بالمَشاهد البصرية الصارخة والصُّور الذهنية التي تستدعي إعمال الفكر.

(7) the First Law

(8) Hedonistic Act Utilitarianism

(9) computable

(10) أو: الشبكات النورونية.

(11) optimal

(12) prime facie duties

(13) Toward Machine Ethics

(14) natural language : لغة الإنسان، خلافا للغة البرمجة أو لغة الآلة.

(15) ethical elder